在余老師帶你學習大數據系列課程的第六章第二節中,我們將深入探討Spark編程模型與其基本架構,這是理解Spark如何實現快速大數據處理的關鍵。Spark之所以能在大數據領域脫穎而出,不僅因其卓越的性能,更得益于其精心設計的編程模型和高度可擴展的架構。本節將系統性地剖析這兩大核心要素,幫助讀者構建清晰的知識框架。

Spark編程模型:簡化并行計算

Spark編程模型的核心抽象是彈性分布式數據集(RDD,Resilient Distributed Dataset)。RDD是一個不可變、可分區的數據集合,能夠跨集群節點并行處理,并具備容錯能力。這種模型將數據處理邏輯轉化為一系列轉換(Transformations)和行動(Actions)操作,極大簡化了分布式編程的復雜度。

核心操作類型:

1. 轉換(Transformations):如map、filter、groupByKey等,它們基于現有RDD創建新的RDD,具有惰性求值特性,即不會立即執行,而是記錄轉換關系,直到遇到行動操作才觸發實際計算。

2. 行動(Actions):如count、collect、saveAsTextFile等,它們觸發計算并返回結果或輸出數據,是作業執行的起點。

通過RDD及其操作,開發者可以像編寫本地集合程序一樣編寫分布式代碼,而無需深入考慮數據分布、節點通信等底層細節。Spark在RDD基礎上發展了更高級的DataFrame和Dataset API,提供結構化數據語義和優化能力,進一步提升了開發效率與執行性能。

Spark基本架構:協同工作的組件生態

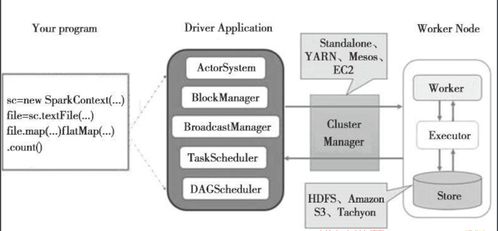

Spark采用主從(Master-Slave)架構,其核心組件協同工作,以實現高效的資源管理和任務執行。主要組件包括:

- Driver Program(驅動程序):

- 作為用戶程序的入口點,負責定義RDD及其轉換/行動操作。

- 將用戶程序轉化為有向無環圖(DAG),并通過DAG調度器將DAG分解為多個階段(Stages)和任務(Tasks)。

- 與集群管理器通信,申請資源并協調任務執行。

- Cluster Manager(集群管理器):

- 負責集群資源的統一管理與分配。Spark支持多種集群管理器,包括Standalone(Spark自帶)、Apache Mesos和Hadoop YARN。

- 根據Driver的請求,為應用分配Executor資源。

- Executor(執行器):

- 在集群的工作節點上運行的進程,每個應用有獨立的Executor。

- 負責執行Driver分配的具體任務,包括數據計算和存儲。

- 將緩存數據保存在內存或磁盤中,加速迭代計算。

任務執行流程:

- Driver將用戶程序解析為DAG,并劃分Stage(基于寬依賴劃分邊界)。

- Driver通過集群管理器啟動Executor。

- Driver將Task分發給對應的Executor執行。

- Executor執行Task,并將結果或狀態反饋給Driver。

- Driver收集最終結果或完成輸出操作。

架構優勢與數據處理效能

Spark架構的核心優勢在于其內存計算與DAG調度優化。通過將數據盡可能保留在內存中,Spark避免了MapReduce等框架頻繁的磁盤I/O開銷,使得迭代算法和交互式查詢速度提升數十倍。DAG調度器能夠優化任務執行計劃,例如進行流水線優化,將多個窄依賴操作合并為一個Stage執行,減少中間結果落盤。

Spark生態提供了Spark SQL(結構化數據處理)、Spark Streaming(流計算)、MLlib(機器學習)和GraphX(圖計算)等庫,在統一編程模型下支持多樣化的數據處理場景,實現了“一站式”大數據分析。

###

掌握Spark編程模型與基本架構,是高效利用Spark進行大數據處理的基石。編程模型通過高層抽象隱藏分布式復雜性,讓開發者聚焦業務邏輯;而分層、協同的架構設計,結合內存計算與智能調度,為快速處理海量數據提供了堅實支撐。在后續學習中,我們將基于此基礎,深入實踐如何利用Spark API解決實際數據處理問題,充分發揮其在大數據時代的威力。