在當今數字化浪潮席卷全球的時代,數據已成為驅動社會進步與商業創新的核心引擎。從社交媒體上的互動信息,到物聯網設備產生的實時流,再到企業運營中積累的交易記錄,海量數據正以前所未有的速度與規模持續生成。擁有數據本身并不直接等同于價值,關鍵在于如何對其進行高效、智能的處理與深度挖掘,從而將原始數據轉化為可指導行動的智慧。

一、海量數據處理:應對巨量、多樣與高速的挑戰

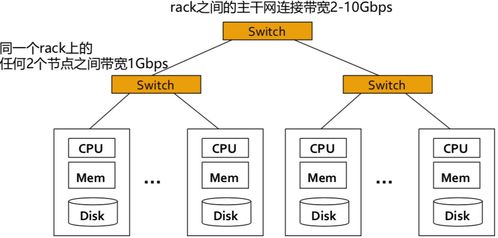

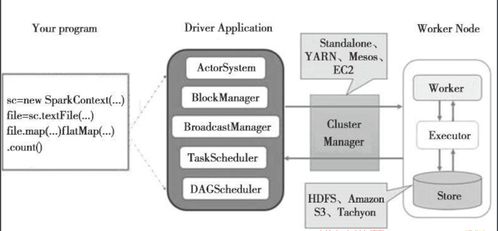

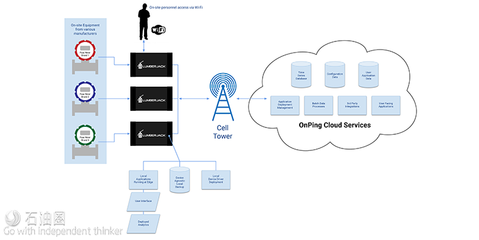

海量數據處理的首要挑戰在于其“海量”特性——數據體量(Volume)巨大,通常達到TB、PB乃至EB級別。這要求處理系統必須具備強大的存儲與計算能力。傳統單機數據庫或處理工具往往難以勝任,分布式計算框架如Hadoop、Spark以及云原生數據倉庫(如Snowflake、BigQuery)應運而生,它們通過將計算任務拆分到成百上千個節點上并行執行,有效解決了規模瓶頸。

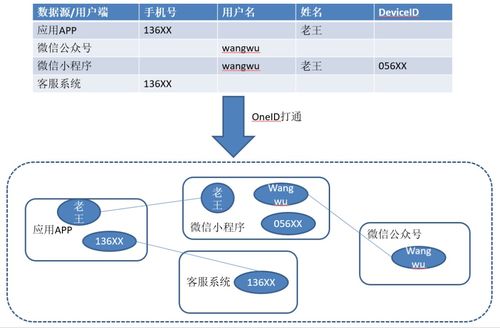

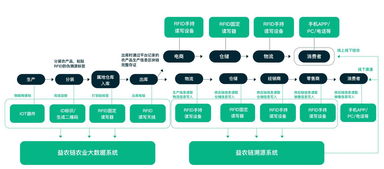

數據多樣性(Variety)日益顯著。結構化數據(如數據庫表格)僅占冰山一角,半結構化(如JSON、XML日志)和非結構化數據(如文本、圖像、音視頻)占比激增。數據處理流程必須能夠兼容多種格式,并具備提取、清洗與整合多源異構數據的能力,例如利用NoSQL數據庫(如MongoDB)存儲靈活模式的數據,或使用數據湖(Data Lake)架構集中存儲原始數據。

數據生成與處理的速度(Velocity)要求極高。在金融風控、實時推薦等場景中,數據價值隨時間快速衰減,批處理模式(如每日ETL作業)已無法滿足需求。流式處理技術(如Apache Kafka、Flink)實現了數據的實時攝入、處理與分析,支持毫秒級響應,讓業務洞察與決策能夠“與數據流動同步”。

二、從數據處理到數據挖掘:發現隱藏的價值模式

數據處理為數據挖掘奠定了堅實的基礎。數據挖掘旨在通過算法從海量數據中發現潛在的模式、關聯與知識,其核心環節包括:

- 數據預處理:這是挖掘成功的關鍵。原始數據常含有噪聲、缺失值與不一致性。通過數據清洗、集成、變換與規約(如特征選擇、降維),可以提升數據質量,為后續分析提供“干凈”的輸入。

- 模式發現:運用機器學習、統計學等方法進行深入探索。例如,通過分類算法(如決策樹、神經網絡)預測客戶行為;通過聚類分析(如K-means)對用戶進行細分;通過關聯規則挖掘(如Apriori算法)發現“啤酒與尿布”式的商品組合規律;通過時序分析預測未來趨勢。

- 知識評估與呈現:將挖掘出的模式轉化為易于理解的見解。這離不開數據可視化(如交互式儀表盤)與清晰的業務解讀,確保分析結果能夠有效支持戰略決策與運營優化。

三、技術融合與最佳實踐

處理與挖掘海量數據是一個系統工程,需要多項技術的協同:

- 云計算與彈性架構:云平臺提供了按需伸縮的計算、存儲資源,使企業無需預先巨額投資硬件,即可靈活應對數據量的波動。

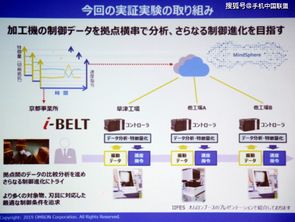

- 人工智能的深化應用:深度學習等AI技術在圖像識別、自然語言處理等非結構化數據挖掘中表現卓越,極大地擴展了數據價值的邊界。

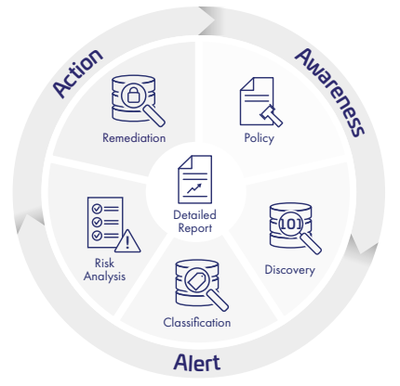

- 數據治理與安全:在利用數據的必須建立完善的數據質量管理、元數據管理、隱私保護(如差分隱私、聯邦學習)與安全合規體系,確保數據的可信、可用與合法使用。

四、展望:走向智能化與價值閉環

海量數據的處理與挖掘將更加自動化與智能化。AutoML技術正嘗試降低建模門檻;增強分析(Augmented Analytics)將AI融入分析全流程,主動提示洞察。最終目標是構建從數據采集、處理、挖掘到決策行動、效果反饋的完整價值閉環,讓數據真正成為流淌在組織血脈中的“智慧血液”,持續賦能精準營銷、智慧城市、科學研究和產業升級等方方面面。

總而言之,面對海量數據,我們既要通過分布式、實時化、云原生的技術棧構建堅固高效的“數據處理管道”,也要借助先進的挖掘算法與AI工具充當敏銳的“價值探測儀”。唯有將二者緊密結合,才能在數據的海洋中精準導航,發掘出驅動未來發展的無盡寶藏。